Quand on s’intéresse aux architectures sous-jacentes des solutions Cloud, on remarque deux points communs:

- Le peu de chiffres qu’on trouve donnent le vertige (oui oui, 1 Péta = 1000 Téra…)

- Très peu d’informations sont divulgués sur l’aspect technique

Il se trouve que Google & Azure ont récemment lâchés quelques informations, surtout sur le réseau 🙂

Facebook est un peu en avance et communique davantage.

Microsoft Azure

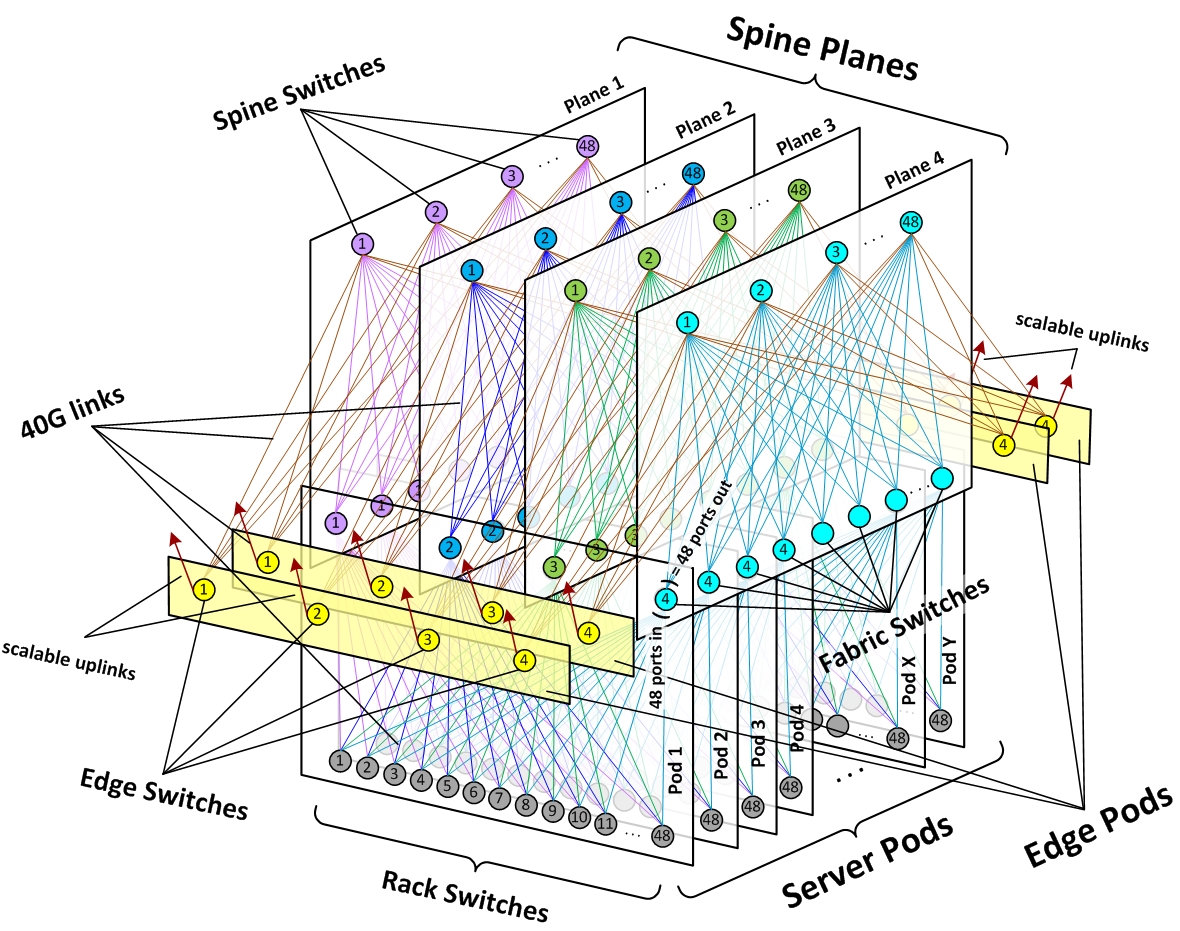

Pour Azure, Voici des slides de Maître Russinovich (cliquer sur l’image pour ouvrir le PowerPoint (29 diapos)):

Fait le plus marquant: ils utilisent des FPGA (processeurs programmables) pour gérer la couche réseau (40GbE/s).

Les dernières infos les plus intéressantes que j’avais eu étaient pendant les TechEd en 2012, toujours de Mark. La vidéo est encore en ligne:

- ~10 personnes pour administrer 100 000 serveurs physiques!

- Démonstration d’une interface d’administration Azure,

- Vue graphique des racks avec les VM,

- Démonstration de self healing de la plateforme,

- Explications sur le bug du 29 février, avec la ligne de commande qui a tout planté

Il semble tout indexer, sauf le contenu de son architecture technique (avec un robots.txt super efficace 😉

Techcrunch a collecté des informations intéressantes, également sur la gestion du réseau (SDN):

http://techcrunch.com/2015/06/17/google-pulls-back-curtain-on-its-data-center-networking-setup/

En 2009, ils avaient publié une visite d’un de leur datacenter, avec l’aspect d’un serveur dans un conteneur:

Ils sont un peu plus bavard, ça doit être dans leur DNA…:

Figure 2:

Un serveur Facebook (un ancien modèle je pense):

Le vide à l’arrière n’est pas juste pour visualiser, c’est vaiment un « trou »:

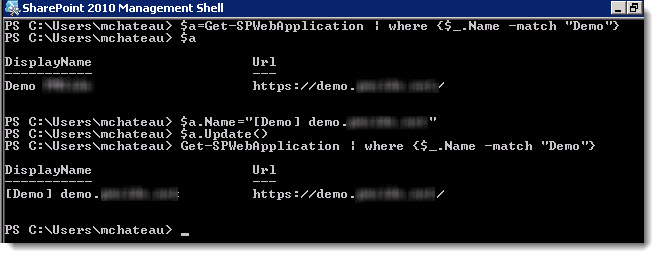

Office365

Les informations les plus présentes concernent la messagerie Exchange:

- Pas de sauvegarde,

- Réplication 3 + 1 Lag à 8 jours (qui descend à 0 en cas de problèmes)

- JBOD pour le stockage (1 banque par disque dur).

- Optimisations via Exchange 2016

Office 365 est indépendant d’Azure, même si certains services y sont hébergés et que la fusion est pour moi en approche.

Amazon

- Ils utilisent Xen pour la virtualisation,

- Ils font leur propres serveurs,

- Basé sur des technos open source

Conclusions

Ils ont des besoins hors normes, mais ils ont aussi les moyens en conséquences:

- Maîtrise complète de toute la chaîne: datacenter, réseau, serveurs, OS, hyperviseur, applications, répartiteurs de charges, moteurs SQL

- Développements dans les couches basses : SDN, FPGA…

- Code source (et personnes pour le faire évoluer): Windows pour Microsoft, Linux pour Google,Facebook et Amazon

- Ils s’appuient sur des projets Open source (OpenFlow, memcache, Hadoop…) mais en ont des extensions propriétaires

- S’il le juge utile, ils peuvent dépenser des moyens colossaux sur certains sujets (comme Google avec son SDN logiciel).

Tout cela leur donne une indépendance forte vis à vis des autres entreprises et leur rachats éventuels part des concurrents. Certains sujets sont certainement plus économique par rapport à la volumétrie (par exemple en économisant $50 par serveur, x300 000)

Là où pour nous c’est parfois le top du top (géo cluster, DRP, LB), c’est le minimum syndical pour eux. Une fois cette barrière levée, un nouveau boulevard s’ouvre avec la montée en charge.